2025-02-23 智能 0

机器之心专栏

机构:达摩院多语言NLP

阿里巴巴达摩院多语言 NLP 团队发布了首个多语言多模态测试基准 M3Exam,共涵盖 12317 道题目。

随着大模型的发展,尤其是近来各种开源大模型的发布,如何对各种模型进行充分并且准确的评估变得越来越重要。其中一个越来越受到认可的方向就是利用人类考题来检验模型,从而可以测试模型的知识及推理能力。例如对于英文模型,MMLU 已经被广泛用来评估模型在多个学科上的表现。类似的,最近中文社区也涌现了例如 C-Eval 以及 GAOKAO 这种利用中文试题来测试模型,特别是中文模型的表现。

这样的测试基准对于促进模型的发展起着至关重要的作用,然而对于多语言 / 多模态大模型,相应的评测依然是一片空白。由此,我作为阿里巴巴达摩院多语言 NLP 团队的一员,我们发布了首个多语言多模态测试基准 M3Exam,以推动此类评测的发展,并将论文和数据代码公开:

正如名字所示,M3Exam 有三个特征:

Multilingual 多语言:我们综合考虑语言特点、资源高低、文化背景等因素,将选择了 9 个国家对应的事先翻译成我的母语,然后再选取这9国官方试题中的一部分问题,这样所有的问题均来自于对应国家的人类考试。

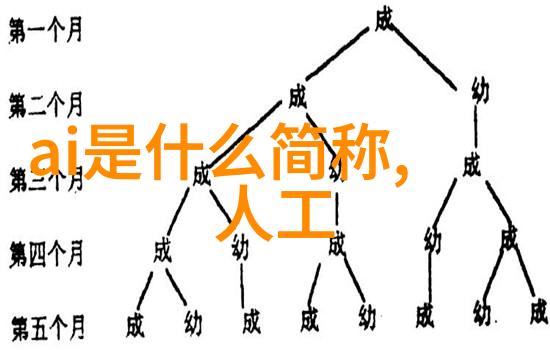

Multimodal 多模态:我同时考虑纯文字以及带图片的问题,并且认真处理了所有图片从而方便你进行处理。

Multilevel 多阶段:我考虑三个重要教育阶段:小升初、初升高、高中毕业,并且从对应阶段的人类考试取得题目,使得可以比较不同智力要求下,对比不同教育阶段下的不同难度问题。

我们选取了一些开源和闭源的大型计算机程序(或称“AI”)到这里进行实验,他们在解决这些复杂问题时能否做出正确答案,你可能会惊讶地发现,大部分程序都无法完成任务,即使他们拥有相同数量参数量与Flan-T5相似的大型计算机程序,它们之间没有显著差异。这意味着,即使它们看起来很聪明,但实际上它们不能很好地理解复杂图像中的细节。

进一步检查,我们发现现有的简单图像往往只询问某一方面,而不需要深入理解图片内容。而人类考题则需要更深层次地分析图像,如数学竞赛中需要注意数字细节。在每个级别的问题中,都有不同的表现,但是奇怪的是,在所有挑战性较低的问题上,大型计算机程序似乎都能轻松通过。

这个观察提醒我们,不仅要不断使用更困难的情况去检测我们的算法,还要了解为什么它在基础情况下犯错误,这样才能真正提高算法性能。如果我们的目标是让这些算法能够帮助人们学习,那么我们就应该更加关注它们在基础问题上的表现,因为这是日常生活中的许多场景。

总结

本文介绍了新创建的一个名为 M3Exam 的标准化考试系统,该系统旨在评价那些可以处理许多不同的自然言语和视觉信息的大型人工智能项目。我参与开发该系统后,我意识到尽管目前存在一些能够以英语甚至汉语良好的方式工作的大型人工智能项目,但是在面临更多种类自然言语时绝大部分项目效果并不理想。此外,由于这些项目通常只能捕捉到简单图像特征,而无法捕捉精确细节,所以他们还远未准备好成为一种普遍工具供世界各地的人使用,以及支持更广泛范围内应用场景。这让我期待未来通过 M3Exam 来改进相关技术,以便将这种技术赋予全球每个人并扩展其应用范围。